Какво е тензорен процесор TPU? Със сигурност знаете какво е CPU (процесор) . Основният процесор на всяко устройство. Intel, AMD и Qualcomm произвеждат такива чипове за вашите устройства от много време. Тук можете да проверите някои от най-известните процесори на всички времена.

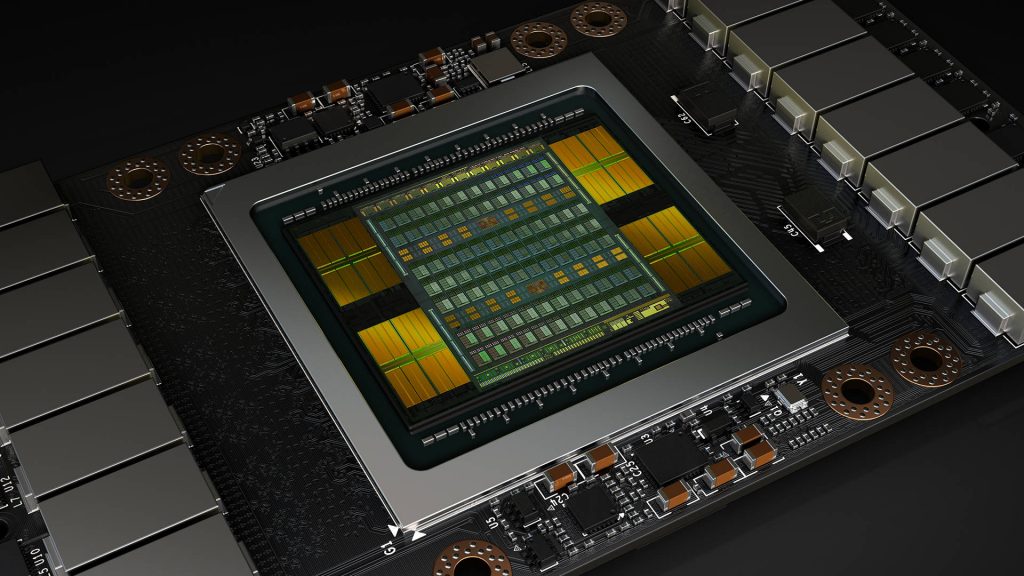

GPU вероятно е нещо, което също знаете. GPU е графичният процесор, който ви помага да възпроизвеждате 3D видео игри на вашето устройство и също така служи за обучение на AI.

Но чували ли сте някога за TPU?

Какво е тензорен процесор (TPU)?

TPU означава Tensor Processing Unit и е вид специфична за приложението интегрална схема (ASIC), създадена от Google. ASIC устройствата станаха популярни с бума на крипто валутите. Тези процесори са много специфични, направени за много малък набор от цели като умножение на матрици и тензорни операции. За разлика от CPU и GPU, които са създадени за общи цели, основната цел на TPU е да ускорят натоварванията на машинното обучение (machine learning). Не може да се използва за множество приложения или за обработка на тежка 3D игра. TPU процесорите са оптимизирани за висока производителност, с ниска консумация на енергия и операции с ниска латентност, необходими за обучение на невронни мрежи (машинно обучение).

На кратко, TPU служи за обучение на модели за машинно обучение, по-евтино и по-ефективно от други решения и все пак осигурява много изчислителна мощност.

Понастоящем TPU са неразделна част от облачната инфраструктура на Google и захранват различни AI приложения като разпознаване на изображения, чат ботове, обработка на естествен език, синтетична реч, двигатели за препоръки и др.

Google ги използва в Google Photos, Google Translate, Google Assistant, Google Search и дори Gmail.

Как работятят TPU процесорите?

TPU процесорите работят по различен начин от CPU и GPU процесорите. Те зареждат параметрите от паметта и ги поставят в матрицата, която използват за умножение, след което зареждат данни от паметта. След това, когато се извършва умножението, резултатите се предават от един умножител на следващия, като едновременно с това се извършва сумиране. Не е необходим достъп до паметта по време на процеса, въпреки че изчислението и предаването на данни могат да бъдат много големи.

Историята на Tensor Processing Unit (TPU)

Google започна да използва TPU процесорите за вътрешни цели през 2015 г., но отне много време, преди да станат достъпни за обществеността. През 2016 г. на Google I/O, конференцията за разработчици на компанията, Google обяви, че ще покаже TPU на света. Технологичният гигант обясни какви представляват тези процесори, показа рамката TensorFlow и говори повече за Tensor Cores (Тензор ядрата). Това, с което Google се похвали, беше, че тези нови процесори ще подобрят производителността на моделите за машинно обучение. TPU v1 е проектиран най-вече за извеждане на задачи и осигурява значително подобрение на енергийната ефективност спрямо CPU и GPU по това време. TPU v2 и TPU v3 разшириха употребата си, като включиха както обучение, така и извод, предлагайки по-висока производителност и по-голяма мащабируемост. TPU v4 и TPU 5 (TPUv5e и TPUv5p) допълнително подобриха процесорите и техните възможности.

TPU версии:

- TPU v1 – 23 TOPS (Тера операции за секунда), 3 GB DDR3 RAM и TDP от 75 W.

- TPU v2 – 45 TOPS, 16 GB HBM и TDP от 280 W.

- TPU v3 – 123 TOPS, 32 GB HBM. и TDP от 220 W.

- TPU v4 – 275 TOPS, 32 GB HBM и TDP от 170 W.

- TPU v5e – 197 (bf16) TOPS, 393 (int8) TOPS и 16 GB HBM.

- TPU v5p – 459 (bf16) TOPS, 918 (int8) TOPS и 95 GB HBM.

- TPU v6 – Предстои да бъде обявено, но се очаква да има 4,7 пъти увеличение на производителността в сравнение с TPU v5e, но това не може да бъде проверено за момента.

Какво представляват тензорните ядра – Tensor Cores?

Тайната на производителността на TPU са тензорните ядра. Те са малките единици във всеки TPU, които обработват специфичните математически операции, участващи в обучението и изпълнението на модели за машинно обучение. За разлика от ядрата в процесорите и графичните процесори, тензорните ядра извършват добавяне на матрично умножение с висока скорост, които са основни операции в алгоритмите за дълбоко обучение. Чрез паралелизиране на тези задачи и оптимизирането им за натоварвания на невронни мрежи, тензорните ядра значително ускоряват изчислителния процес, позволявайки по-кратко време за обучение и по-ефективно заключение.

Какво е TensorFlow?

TensorFlow е рамка за машинно обучение, създадена от Google. Тя е с отворен код и предлага цялостна екосистема за изграждане и внедряване на модели за машинно обучение, включително инструменти за обучение на модели, предварителна обработка на данни и обслужване. Задачата на TensorFlow е да бъде гъвкава и мащабируема, така че Google да може да я предлага като облачна услуга. TPU процесорите са тясно интегрирани с TensorFlow, което позволява на разработчиците да използват силата на TPU безпроблемно в рамките на работните си процеси на TensorFlow.

Предимства на TPU

- Висока производителност. За някои специфични задачи на машинното обучение този тип процесор предлага превъзходна производителност. TPU процесорите могат драстично да намалят времето за обучение и да ускорят заключенията. Тензорите могат да изпълняват множество операции паралелно.

- Енергийна ефективност. Ефективността е основна грижа и тези процесори наистина се отличават с осигуряването на висока изчислителна мощност, без да консумират излишна енергия.

- Мащабируемост. Google създаде TPU процесорите с идеята да бъдат лесно мащабируеми и да могат да се справят с големи работни процеси на машинно обучение.

- Интеграция с TensorFlow. TPU процесорите работят безпроблемно с TensorFlow, което улеснява разработчиците да изпълняват модели за машинно обучение в мащаб.

- Може да ускори различни AI натоварвания като PyTorch и JAX.

Недостатъци на TPU процесорите

- Цена. В зависимост от размера на вашия проект, особено ако проектът е малък, цената може да бъде твърде скъпа в сравнение с други решения.

- Ограничена гъвкавост. TPU процесорите са много по-малко гъвкави в сравнение с CPU и GPU чиповете за други видове изчисления. Те са добри само за работа с невронни мрежи.

- Зависимост от Google Cloud. Не можете просто да закупите устройство с TPU процесори вътре. За да ги използвате, трябва да платите за абонамент за Google Cloud, което създава силна зависимост.

Кога да използвате TPU вместо CPU или GPU?

Използвайте TPU, за:

- Бързо обучение на големи и сложни модели на машинно обучение.

- Направа на извод върху широкомащабни модели с високи изисквания за производителност.

- Оптимизиране на енергийната ефективност за задачите на машинното обучение.

- Модели с дълъг период на обучение – седмици или месеци.

- Модели, с преобладаващи матрични изчисления.

- Да се възползвате от тясната интеграция с TensorFlow за безпроблемно внедряване.

Кога да използвате GPU вместо CPU или TPU ?

Използвайте GPU, за:

- Модели, които не са написани на TensorFlow.

- Модели с голям брой персонализирани операции на TensorFlow, които частично трябва да работят на друг вид процесори.

- Модели, при които проблемът е, че източникът не съществува или е твърде труден за промяна.

- Модели с операции на TensorFlow, които не са достъпни в Cloud TPU.

- Средни и големи модели с големи партиди.

- Обучение и управляване на модели за машинно обучение, които не са изключително базирани на невронни мрежи.

- Справяне се с различни изчислителни задачи извън просто машинно обучение.

- Колаборация с по-голяма общност от разработчици и по-широка софтуерна поддръжка за рамки за машинно обучение.

Кога да използвате CPU вместо TPU или GPU?

Използвайте CPU процесори, за:

- Компютърни задачи с общо предназначение.

- Изпълняване на работни натоварвания, които не изискват специализираното ускорение, осигурено от TPU или GPU.

- Задачи, които се възползват от гъвкавостта и еднонишковата производителност на процесорите.

- Бързо създаване на прототипи.

- Опростени модели с кратък период на обучение.

- Малки модели с малки партиди.

- Персонализирани операции на TensorFlow, които са написани на C++.

TPU срещу GPU срещу CPU

| Параметър | TPU (Тензорен процесорен блок) | GPU (Графичен процесор) | CPU (Централен процесор) |

| Основна употреба | Машинно обучение и AI задачи | Рендиране на графики, машинно обучение и паралелна обработка | Обща изчислителна цел и серийна обработка |

| Архитектура | Специфична ASIC (Интегрална схема за конкретни приложения) | Многоядрена архитектура | Малко ядра с висока тактова честота |

| Производителност | Оптимизиран за матрични умножения и тензорни операции | Висок паралелизъм за масови изчислителни задачи | Висока производителност на единична нишка |

| Енергийна ефективност | Висока за специфични ML задачи | Умерена, зависи от задачата | Варира, обикновено по-ниска за интензивни изчисления |

| Програмни рамки | TensorFlow, потребителски рамки | CUDA, OpenCL, DirectCompute | Езиците за общо предназначение (C, C++, Python и др.) |

| Латентност | Ниска за ML задачи | Ниска за паралелни задачи, по-висока за серийни задачи | Ниска за серийни задачи, по-висока за паралелни задачи |

| Цена | Висока, особено за съвременни версии | Висока, особено за висококласни модели | Варира, обикновено по-ниска от GPU и TPU |

| Широчина на паметта | Висока за тензорни операции | Висока за графични и паралелни обработващи задачи | Умерена до висока, в зависимост от модела |

| Гъвкавост | Ниска, процесор, проектиран за специфични задачи | Умерена. Многофункционален процесор, но най-добър за паралелни задачи | Висока. Многофункционален процесор за широк спектър от приложения |

Трябва ли да изпробвате TPU за вашите нужди от машинно обучение?

Зависи от вашите специфични нужди. Ако имате идея за малък проект за машинно обучение, по-добре да се ориентирате към обикновен процесор. Ако търсите решение за обучение на голяма невронна мрежа, проверете дали имате нужда от TensorFlow или не. Ако отговора е не, можете да изберете GPU решение за обучение на AI.

Ако вашият проект е голям, включва обучение на невронни мрежи или изводи и се нуждаете от висока ефективност и висока производителност, тогава TPU процесорите могат да бъдат отличен избор.

Просто не забравяйте да направите добра оценка на работното си натоварване и целите за ефективност, преди да направите прибързани заключения и да направите своя избор.